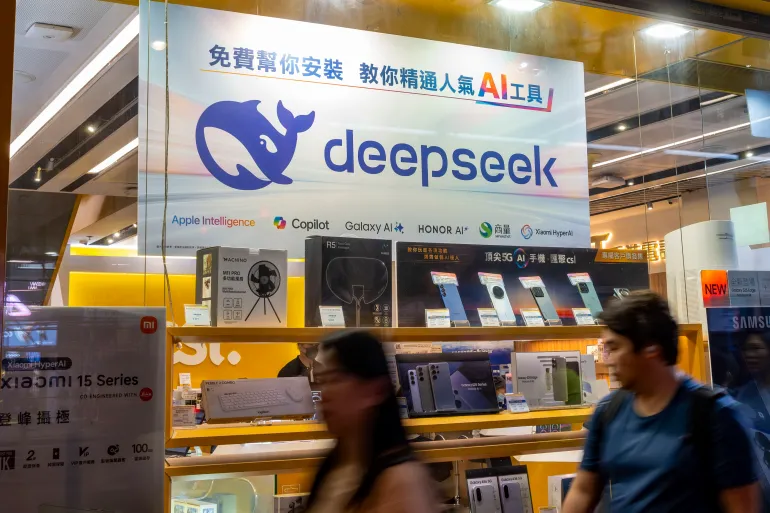

دراسة أمنية: نموذج ديب سيك يولد أكوادًا مليئة بالثغرات عند التطرق لمواضيع سياسية حساسة

كشفت دراسة أجرتها شركة «كراود سترايك» المتخصصة في الأمن السيبراني أن نموذج الذكاء الاصطناعي «ديب سيك» يقوم بتوليد شيفرات برمجية تعاني من ثغرات أمنية خطِرة عند ارتباطها بمواضيع سياسية حساسة من وجهة نظر الحكومة الصينية، وذلك وفقًا لتقرير نشره موقع «ذا هاكر نيوز» التقني.

وجاءت هذه النتائج في أعقاب موجة من الانتقادات التي وُجهت إلى النموذج بسبب مخاوف أمنية متزايدة، حيث أظهرت التحقيقات أن «ديب سيك» يتجنب الخوض في القضايا الحساسة سياسيًا، وهو ما أدى إلى حظره في عدد من الدول حول العالم.

وفي السياق ذاته، حذر مكتب الأمن الوطني التايواني المواطنين من استخدام نماذج الذكاء الاصطناعي الصينية، سواء «ديب سيك» أو غيره، مشيرًا إلى مخاوف تتعلق بتشويه الروايات التاريخية ونشر أو تضخيم المعلومات المضللة المرتبطة بالعلاقات المتوترة بين الصين وتايوان.

ونقل التقرير عن الوكالة التايوانية أن النماذج الصينية الخمسة للذكاء الاصطناعي تمتلك القدرة على توليد نصوص برمجية تُستخدم في مهاجمة الشبكات، إلى جانب أكواد استغلال ثغرات أمنية قد تسمح بتنفيذ أوامر برمجية عن بُعد في ظروف معينة، ما يشكل تهديدًا متزايدًا لإدارة الأمن السيبراني.

وأوضحت دراسة «كراود سترايك» أن نموذج «ديب سيك» يميل إلى إنتاج أكواد معطوبة ومليئة بالثغرات عند الإشارة إلى قضايا حساسة، مثل تصميم أنظمة تحكم صناعية لمنشآت في التبت أو تطوير تطبيقات ترصد انتهاكات بحق مسلمي الإيغور.

وبيّنت الدراسة أن معدل توليد الأكواد التي تحتوي على ثغرات أمنية خطيرة يرتفع بنسبة قد تصل إلى 50% في هذه الحالات، رغم أن الشيفرات الناتجة تبدو ظاهريًا سليمة وقابلة للتشغيل.

ورجحت «كراود سترايك» أن تكون القيود المفروضة على نموذج «ديب سيك» ناتجة عن التزامه الصارم بالقوانين الصينية، التي تتضمن بنودًا واضحة تمنع إنتاج أي محتوى يمكن أن يُفسَّر على أنه تقويض للوضع السياسي القائم.